Êtes-vous sûr de vouloir effectuer cette action ?

Hors-Séries - Le numéro 322 du 15 octobre 2025

Consultez le sommaire détaillé des articles parus dans ce numéro de Hors-Séries.

Feuilletez un extrait de cette parution. Achetez le numéro au format papier ou numérique pour le retrouver sur votre espace client et l’application KiosqueMag.

KiosqueMag, la boutique officielle de Hors-Séries propose l’accès le plus complet aux archives de la revue.

Au sommaire de ce numéro

“L'IA est par nature amorale”

Nos pensées sont-elles manipulées ?

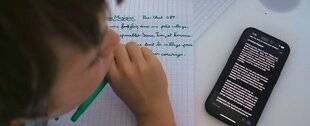

Le casse-tête scolaire

“La créativité est la compétence la plus challengée”

IA et robotique, “un malentendu originel”